A medida que nos embarcamos en la era de la IA, las apuestas éticas son altas. Anthropic, una startup dirigida por ex investigadores de OpenAI, lo reconoce. Han elaborado una “constitución” ética para su chatbot, Claude, para garantizar una navegación responsable en el mundo digital. Este movimiento audaz combina diversos principios, abordando el poder transformador de la IA y los riesgos potenciales.

Profundicemos en esta intrigante “constitución” y sus implicaciones para la IA y comparemos Claude de Anthropic con ChatGPT de Open AI.

Constitución de Claude: un marco ético para la IA

Tomando prestado de fuentes heterogéneas como la Declaración Universal de Derechos Humanos de las Naciones Unidas y las regulaciones de desarrollo de aplicaciones de Apple, la “constitución” de Claude es un testimonio de la fusión creativa de la ética y la tecnología.

Esta constitución no es ornamental, es instrumental. Es la base de los procesos cognitivos de Claude, informando su toma de decisiones y estableciendo límites para las interacciones.

Imagine un programa de computadora leyendo las Convenciones de Ginebra antes de decidir eliminar un archivo. Ese es el tipo de diligencia debida ética para la que está diseñado Claude.

Por ejemplo, cuando se enfrenta al dilema de la privacidad del usuario frente a la prestación de un servicio personalizado, la constitución guía a Claude a priorizar la confidencialidad del usuario, basándose en el énfasis de la ONU en el derecho a la privacidad.

Más allá de las reglas estrictas: el enfoque de Anthropic hacia la IA ética

El enfoque de Anthropic rompe con el paradigma tradicional de reglas estrictas. No buscan simplemente programar a Claude con una lista exhaustiva de lo que se debe y lo que no se debe hacer.

En cambio, su enfoque radica en incorporar principios éticos dentro de Claude utilizando el aprendizaje por refuerzo .

Imagínese esto: cuando un niño se porta mal, no solo lo castigamos. Explicamos por qué la acción estuvo mal y guiamos al niño hacia un comportamiento más aceptable. Esa es la filosofía pedagógica que Anthropic aplica a Claude.

Por ejemplo, si Claude propone una respuesta que viola sus pautas éticas, no solo se le reprende, sino que también se le muestra la acción ética apropiada. Con el tiempo, Claude aprende a alinear su comportamiento con su constitución ética.

ChatGPT vs. Claude: un estudio comparativo

ChatGPT de OpenAI y Claude de Anthropic representan dos incursiones de vanguardia en la conversación impulsada por IA.

- ChatGPT: Desarrollado por GPT-3 de OpenAI, ChatGPT se ha hecho un nombre por sí mismo con su capacidad para generar texto similar al humano. Basado en una arquitectura transformadora, aprovecha el aprendizaje no supervisado en un corpus masivo de texto de Internet para proporcionar respuestas. ChatGPT no tiene una comprensión o creencias inherentes, pero imita la comprensión al predecir la siguiente palabra en una oración según el contexto.

- Claude: Claude de Anthropic, por otro lado, se basa en una propuesta única. No solo se enfoca en generar respuestas coherentes sino que también se adhiere a una constitución ética. Este marco guía la toma de decisiones de Claude, con el objetivo de hacerla más ética. Su modo operativo se inclina hacia el aprendizaje por refuerzo en lugar de respuestas puramente basadas en predicciones.

- Comparaciones: tanto ChatGPT como Claude tienen como objetivo una conversación sofisticada y humana. Son demostraciones impresionantes del potencial de la IA en la comprensión y generación de idiomas. Ambos aprovechan grandes cantidades de datos de entrenamiento y potentes algoritmos.

- Contrastes: La diferencia clave radica en su enfoque de las consideraciones éticas. ChatGPT, aunque es muy avanzado, no tiene un marco ético específico que guíe sus respuestas. Mientras tanto, Claude tiene una constitución que da forma a sus interacciones, ofreciendo potencialmente una IA más responsable. El enfoque de aprendizaje por refuerzo de Anthropic también difiere del modelo basado en predicción de ChatGPT, lo que posiblemente conduce a diferentes dinámicas de conversación.

Si bien ChatGPT y Claude comparten el objetivo común de mejorar la conversación de IA, representan estrategias divergentes. Sus contrastes iluminan aspectos fascinantes del desarrollo de la IA y la búsqueda continua de una IA ética.

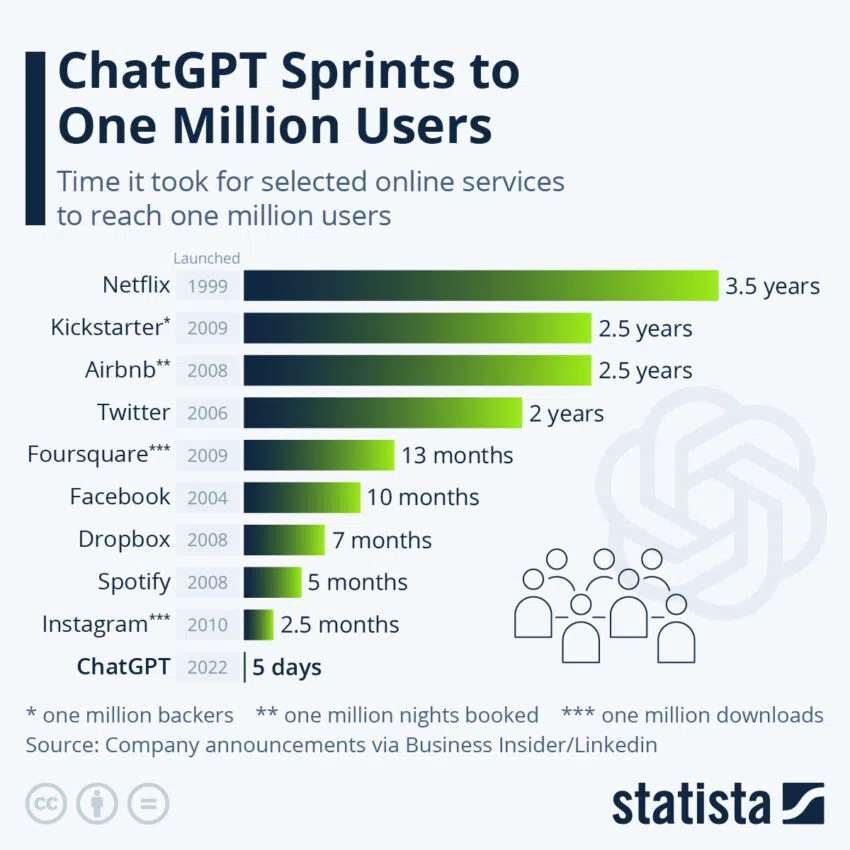

Además, ChatGPT fue un éxito instantáneo, mientras que Claude aún se está implementando.

El futuro de la IA ética

El experimento de Anthropic tiene enormes implicaciones para la comunidad de IA en general. Presenta una plantilla intrigante para el desarrollo ético de la IA, un modelo basado en la constitución.

Sin embargo, como todos los modelos, tiene sus limitaciones. En primer lugar, está la cuestión del relativismo cultural. Lo que una cultura ve como ético puede ser visto de manera diferente por otra. Asegurar que la constitución de Claude sea universalmente aplicable es una tarea hercúlea.

Además, existe el riesgo de un sesgo arraigado. La constitución de Claude, al ser un producto del diseño humano, puede reflejar inconscientemente los prejuicios de sus creadores.

Para abordar estos desafíos, es fundamental fomentar aportes diversos y un debate sólido dentro de la comunidad de IA.

Los esfuerzos de Anthropic subrayan la necesidad de la participación de la comunidad en la ética de la IA. El enfoque de la constitución es pionero, pero también destaca la importancia de un diálogo colectivo.

Está claro que el camino hacia la IA ética involucra no solo a los gigantes tecnológicos y las nuevas empresas, sino también a los responsables políticos, los especialistas en ética y los usuarios cotidianos.

El viaje es complejo y la hoja de ruta poco clara, pero los esfuerzos de Anthropic ofrecen una idea del destino: un ecosistema de IA que no solo es técnicamente avanzado, sino también éticamente consciente. Es una vista expansiva, llena de promesas y desafíos, y que justifica nuestra exploración colectiva.