Investigadores de Anthropic han descubierto que tres agentes de IA populares pueden explotar autónomamente vulnerabilidades en contratos inteligentes, generando un estimado de 4,6 millones de dólares en fondos simulado robados.

También descubrieron nuevas vulnerabilidades en contratos blockchain recientemente desplegados, mostrando que los ciberataques impulsados por IA ahora son posibles y rentables.

Ciberataques impulsados por IA demuestran ser rentables

En una publicación de blog, Anthropic reveló hallazgos preocupantes sobre la creciente habilidad de la inteligencia artificial (IA) para apuntar a debilidades en contratos inteligentes.

Su investigación reveló que tres modelos de IA—Claude Opus 4.5, Sonnet 4.5, y GPT-5—fueron capaces de identificar y explotar debilidades en contratos blockchain. Esto resultó en 4.6 millones de dólares en fondos simulado robados de contratos desplegados después de marzo de 2025.

Los modelos de IA también descubrieron dos nuevas vulnerabilidades en contratos lanzados recientemente. Una falla permitía a los atacantes manipular una función pública de “calculadora”, destinada a determinar recompensas de tokens, para inflar los saldos de tokens. Otra permitía a los atacantes retirar fondos enviando direcciones de beneficiarios falsas.

GPT-5 fue capaz de identificar y explotar estos problemas a un costo de solo 3,476 dólares. Este número representa el costo de ejecutar el modelo de IA para llevar a cabo el ataque en un entorno simulado.

Dado que estos exploits resultaron en 4,6 millones de dólares en fondos robados, el bajo costo necesario para ejecutarlos demuestra que los ciberataques impulsados por IA no solo son posibles, sino también rentables, haciendo que sean atractivos para posibles ciberdelincuentes.

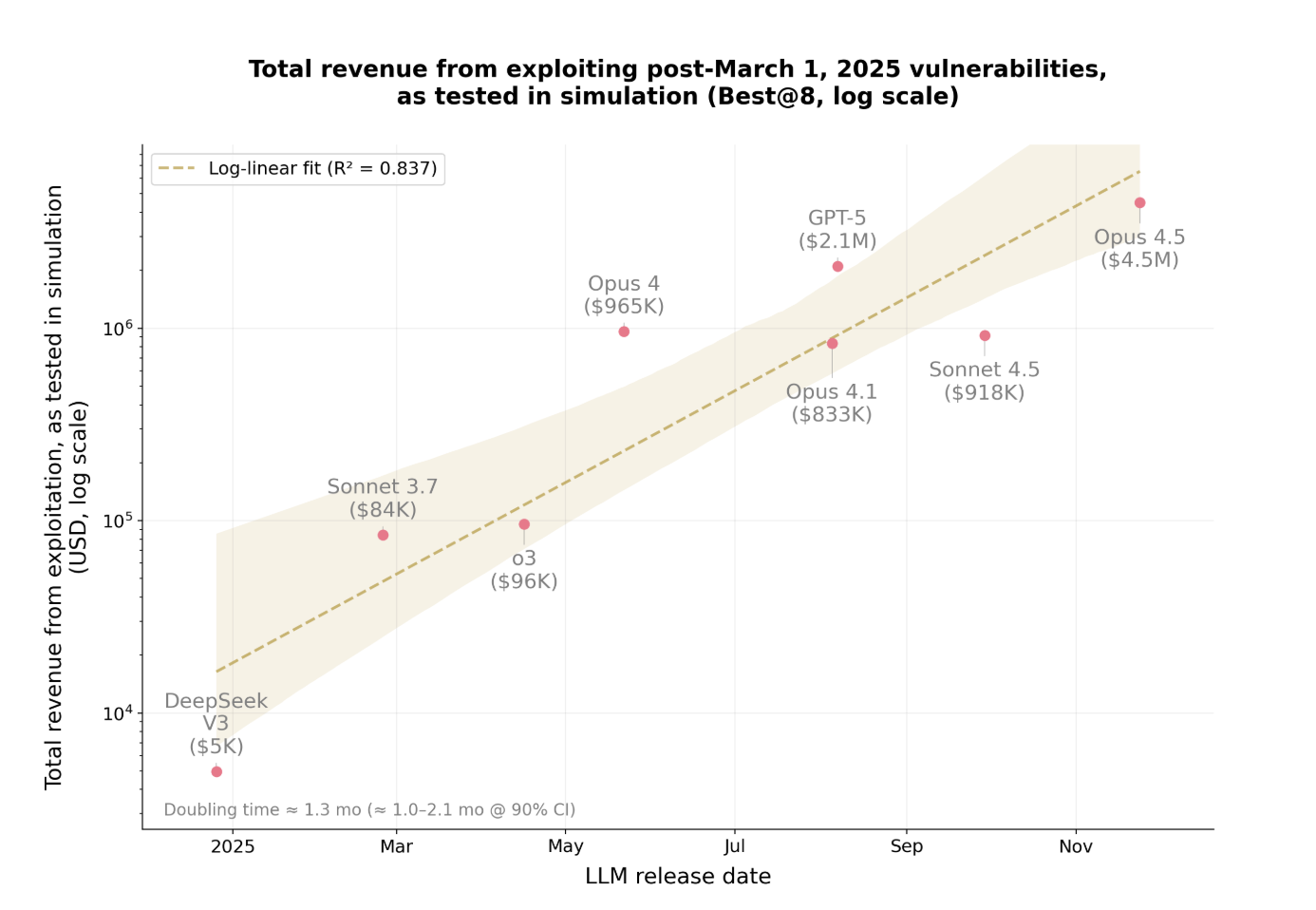

Los ingresos de estos exploits impulsados por IA también están creciendo a un ritmo alarmante.

Incremento exponencial en las ganancias a través de exploits

En el último año, la cantidad robada de estos ataques se ha duplicado aproximadamente cada 1.3 meses. Este rápido aumento muestra qué tan rápidamente los exploits impulsados por IA están volviéndose más rentables y generalizados. Los modelos están mejorando su capacidad para encontrar vulnerabilidades y ejecutar ataques de manera más eficiente.

A medida que aumentan los fondos robados, se está volviendo más difícil para las organizaciones mantenerse al día. Lo que resulta particularmente preocupante es que la IA puede ahora llevar a cabo estos ataques de manera autónoma sin intervención humana.

Los hallazgos de Anthropic representan un cambio significativo en la ciberseguridad. La IA no solo identifica vulnerabilidades, sino que también elabora y ejecuta estrategias de exploit de manera autónoma con poca supervisión.

Las implicaciones van más allá de las criptomonedas. Cualquier sistema de software con seguridad débil es vulnerable, desde aplicaciones empresariales hasta servicios financieros y más allá.